3月15日,#GPT4做一个网站只要十秒#登上热搜。

当地时间周二(3月14日),人工智能研究公司OpenAI公布了其大型语言模型的最新版本——GPT-4。

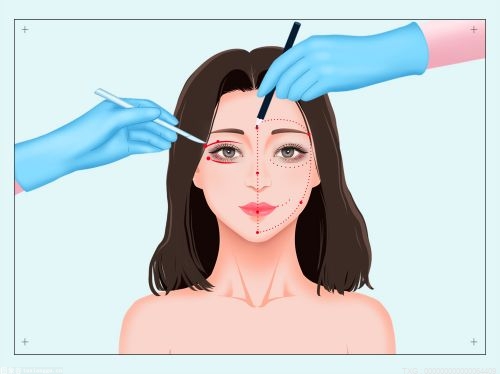

在官方演示中,GPT-4几乎就只花了十来秒的时间,识别了手绘网站图片,并根据要求实时生成了网页代码制作出了几乎与手绘版一样的网站。

(相关资料图)

(相关资料图)

图片来源:视频截图

除了普通图片,GPT-4还能处理更复杂的图像信息,包括表格、考试题目截图、论文截图、漫画等,例如根据专业论文直接给出论文摘要和要点。

此外,该公司还表示,GPT-4在许多专业测试中表现出超过绝大多数人类的水平。OpenAI还称,GPT-4参加了多种基准考试测试,包括美国律师资格考试Uniform Bar Exam、法学院入学考试LSAT、“美国高考”SAT数学部分和证据性阅读与写作部分的考试,在这些测试中,它的得分高于88%的应试者。

OpenAI表示,在内部评估中,GPT-4产生正确回应的可能性要比GPT-3.5高出40%。而且GPT-4是多模态的,同时支持文本和图像输入功能。OpenAI称,GPT-4比以前的版本“更大”,这意味着其已经在更多的数据上进行了训练,并且在模型文件中有更多的权重,这使得它的运行成本更高。

据OpenAI介绍,在某些情况下,GPT-4比之前的GPT-3.5版本有了巨大改进,新模型将产生更少的错误答案,更少地偏离谈话轨道,更少地谈论禁忌话题,甚至在许多标准化测试中比人类表现得更好。

例如,GPT-4在模拟律师资格考试的成绩在考生中排名前10%左右,在SAT阅读考试中排名前7%左右,在SAT数学考试中排名前11%左右。

OpenAI表示,已经与多家公司合作,要将GPT-4结合到他们的产品中,包括Duolingo、Stripe和Khan Academy。GPT-4模型也将以API的形式,提供给付费版ChatGPT Plus的订阅用户。开发者可以注册,用它打造应用。微软此后表示,新款的必应(Bing)搜索引擎将运行于GPT-4系统之上。

OpenAI表示,虽然两个版本在日常对话中看起来很相似,但当任务复杂到一定程度时,差异就表现出来了,GPT-4更可靠、更有创造力,能够处理更微妙的指令。“在我们的内部评估中,它产生正确回应的可能性比GPT-3.5高40%。”

此外,GPT-4还有了一个质的飞跃——可以开始处理图像。经常使用ChatGPT的人肯定知道,它只能处理文本,但GPT-4开始接受图像作为输入介质。

据Open AI演示,用户提问:解释下图的笑点是什么,并对图片中的每部分进行描述。GPT-4的回答如下图所示:

据封面新闻,不过, 与早期的GPT模型一样,GPT-4仍然存在一定的局限性。

OpenAI称,它并不完全可靠,可能会出现推理错误 ,“GPT-4缺乏对绝大多数数据切断后(2021年9月)发生的事件的了解,并且无法从中吸取经验教训……它有时会出现简单的推理错误,它会轻信用户明显的虚假陈述,有时它会像人类一样在难题上失败,例如在它生成的代码中引入安全漏洞。”

基于此,OpenAI提醒,用户在使用语言模型时应格外小心,最好辅助以人工审查、附加上下文、或完全避免在高风险情况下使用它。

由于仅限于Plus订阅用户使用,当晚,大批新订用户涌入,以至于OpenAI的付款系统被挤爆了。

OpenAI透露,摩根士丹利正在使用GPT-4来组织数据,而电子支付公司Stripe正在测试GPT-4是否有助于打击欺诈。其他客户还包括语言学习公司Duolingo、Khan Academy和冰岛政府。

据不完全统计,截至今年3月初,A股已有近20家上市公司宣布相关业务已经接入类似ChatGPT技术,或正在研究相关技术与数字人结合的应用场景。国盛证券在研报中表示,以GPT系列为代表的大型语言模型(LLM)能教会机器以统计方式理解自然语言,完成此前人类进行的内容读取和理解。随着多模态带来的模型全面化,人工智能将向着拥有人类解释能力这一目标更进一步。